什么是robots.txt文件?对网站优化有什么作用?

发布:管理员 日期:2022-09-21 阅读: 次

百度百科介绍:robots是网站跟爬虫间的协议,用简单直接的txt格式文本方式告诉对应的爬虫被允许的权限,也就是说robots.txt是搜索引擎中访问网站的时候要查看的第一个文件。当一个搜索蜘蛛访问一个站点时,它会首先检查该站点根目录下是否存在robots.txt,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围;如果该文件不存在,所有的搜索蜘蛛将能够访问网站上所有没有被口令保护的页面。

什么是Robots.txt文件?

Robots.txt 是网站里的一个文件,它告诉搜索引擎抓取工具(蜘蛛)禁止或允许抓取网站的哪些内容。主流搜索引擎(包括 Google、Bing 和 Yahoo)都能够识别并尊重 Robots.txt的要求。如需查看网站是否有Robots文件,请访问网址:域名/robots.txt,譬如https://loyseo.com/robots.txt。

Robots.txt 怎么运作?

要想知道Robots.txt文件是如何发挥作用的,就要了解搜索引擎的工作机制:①爬行②抓取③索引(也可以叫做收录)。

爬行:搜索引擎的蜘蛛在爬网的过程中,通过从其他网站中获取到了你的网址,那么它就会记录下这个网址。还有,你也可以通过搜索引擎的站长工具,譬如在Google Search Console中提交你的网站地图(Sitemap),告知搜索引擎你的网站网址。

抓取:蜘蛛通过访问之前爬行获取的网址,抓取你网页里的内容并存档。爬行就像记录商店门牌号,抓取就是进店拍照。那是否你提交的网址一定都会被抓取呢?不一定,因为搜索引擎分配给你的抓取份额是有限的,如果你的站点很小,那基本不用担心,那如果你的站点规模庞大,那么,对于使用Robots.txt文件,禁止某些不必要的内容被抓取,就很用必要了,这能让抓取份额用在有意义的地方,而不是被无意义的内容消耗。

当搜索引擎的蜘蛛来到网站时,首先会阅读这个Robots.txt文件,了解到什么网址禁止被抓取后,搜索引擎便不去抓取这些页面。

如果这些网址存在其他的导入链接(即外链时),譬如其他网址给了你一条外链指向这个内容,那么这个页面还是可能会被索引的,虽然,因为无法抓取而不能直接获取页面的内容,但是搜索引擎会根据外链提供的相关信息对这个内容进行索引并展示在搜索结果中。

所以,如果你想一个内容不被抓取,也不被索引,那么你还需要通过在内容中设置noindex元标记(meta robots)。

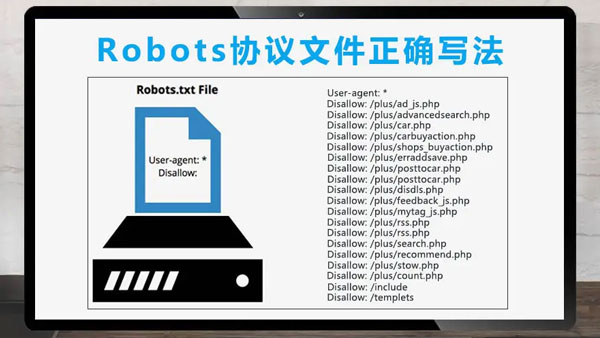

怎样制作robots.txt文件?

1. 允许所有SE收录本站:robots.txt为空就可以,什么都不要写。

2. 禁止所有SE收录网站的某些目录:

User-agent: *

Disallow: /目录名1/

Disallow: /目录名2/

Disallow: /目录名3/

3. 禁止某个SE收录本站,例如禁止百度:

User-agent: Baiduspider

Disallow: /

4. 禁止所有SE收录本站:

User-agent: *

Disallow: /